Optimizing Capacity, Connectivity and Capability of the Cloud

Home > CXL 内存计划

数据中心挑战

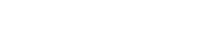

数据中心面临三大内存挑战,这些是实现更出色性能和总体拥有成本 (TCO) 的障碍。

其中第一个挑战是当前服务器内存层级的限制。直连式 DRAM 和固态硬盘 (SSD) 存储存在三个量级的延迟差距。处理器耗尽直连式内存的容量时,必须转向 SSD,这时处理器只能等待。这一等待(即延迟)会对计算性能造成极大的负面影响。

第二,多核处理器中的核心数量扩展速度比主内存通道快得多。这样一来,超过特定数量的处理器核心就得不到内存带宽,弱化额外核心的优势。

最后,随着计算加速(其中加速器有自己的直连式内存)的日益普及,内存资源利用不足或滞留的问题也愈发显著。

CXL 技术如何彻底变革数据中心

利用 CXL 技术,行业正在通过分层内存解决方案和可组合架构,以随需应变方式匹配计算、内存和存储的数量,解决广泛的工作负载的需要。了解 200 多家公司(包括从 IP、芯片、平台、系统原始设备制造商到行业巨头的数据中心价值链中每个环节的领导者)如何强强联手,彻底变革数据中心。

使用 CXL 迎接挑战

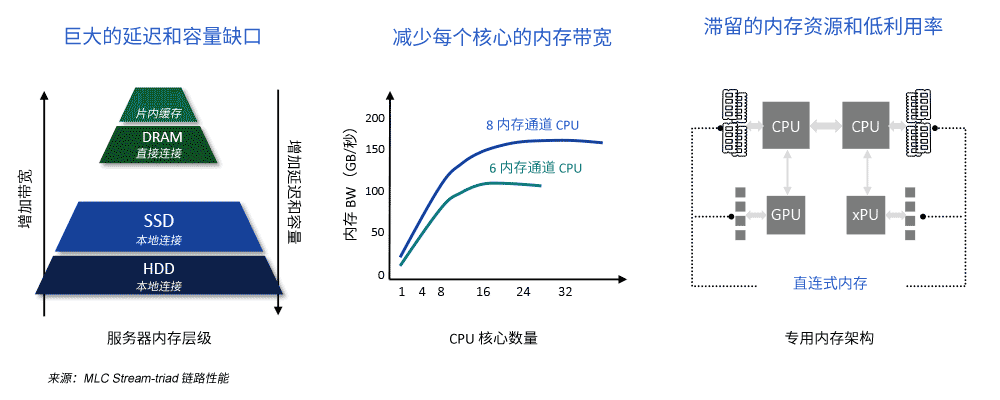

数据中心内存挑战的解决方案是一种具有高引脚效率的内存技术,可以灵活地为处理器提供更多带宽和容量。Compute Express Link™ (CXL™) 是广泛支持的行业标准解决方案,开发用于在处理器、加速器和内存设备之间提供低延迟的内存缓存一致链路。

CXL 利用数据中心无所不在的 PCI Express® 作为其物理层。使用 CXL,可以实现新内存层级,弥合直连式内存与 SSD 之间的差距,释放多核处理器的潜力。

此外,CXL 的内存缓存一致性允许在处理器和加速器之间共享内存资源。共享内存对于解决这个滞留内存资源问题至关重要。

CXL 内存扩展和池化

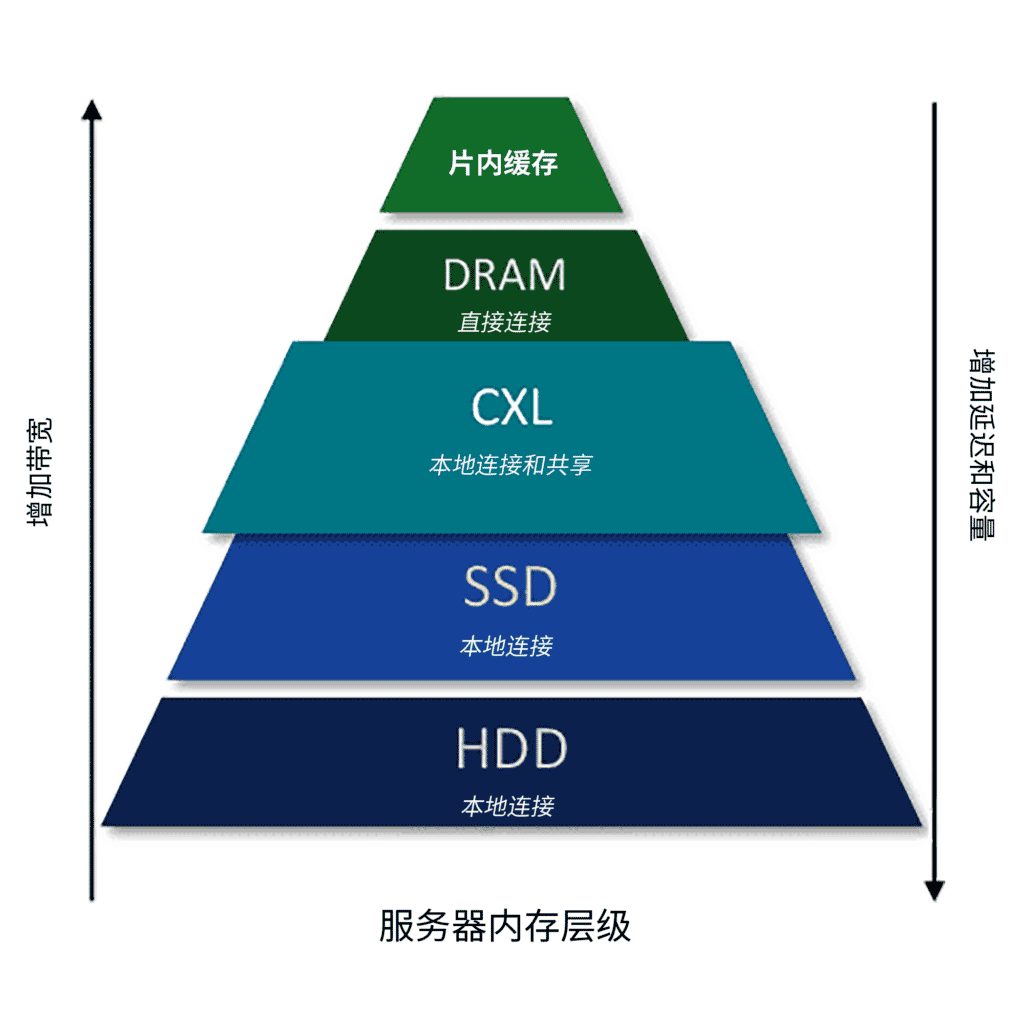

CXL 支持许多使用模型,提供递增的带宽和容量水平,以便缩短延迟。其中第一个使用模型(即内存层级)显示在下图右侧,是一种内存扩展,提供更高的带宽和容量,延迟接近直连式内存。

CXL 内存池化允许多个计算节点(处理器和加速器)以随需应变的方式存取多个 CXL 内存设备,以便灵活、高效地存取更大的内存带宽和容量。这一概念也可扩展到 CXL 交换和网状连接架构。

Rambus CXL 内存计划

Rambus 正在开发 CXL 内存计划解决方案,引领数据中心性能和效率的新时代。此计划是 Rambus 在最先进内存和芯片间互连产品领域的 30 年领先历史中的最新篇章。

CXL 内存扩展和池化所需的芯片解决方案需要综合许多重要技术。Rambus 凭借在内存和 SerDes 子系统、半导体和网络安全、大容量内存接口芯片和计算系统架构领域的专业知识,使未来数据中心的突破性 CXL 内存解决方案成为可能。

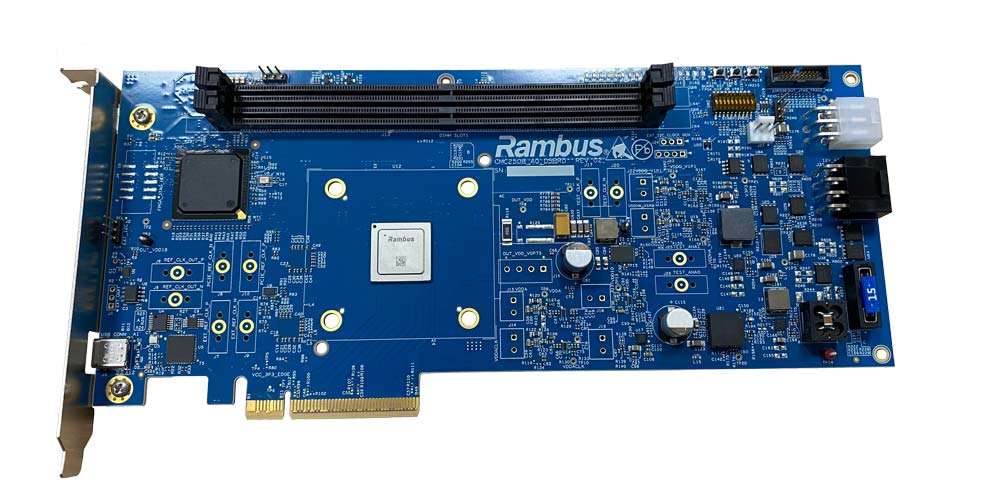

Rambus CXL 平台开发工具包

Rambus 提供了 CXL 平台开发工具包 (PDK),支持模块和系统制造商对用于人工智能基础架构和其他先进系统的基于 CXL 的内存扩展和池化解决方案制作原型并进行测试。PDK 可与来自所有主流内存供应商的支持 CXL 1.1 和 CXL 2.0 的处理器和内存互操作。它利用当今可用的硬件,加速开发基于 CXL 的下一代全堆栈解决方案。

PDK 可交付成果:

- CXL 硬件平台(附加卡),包含原型 Rambus CXL 内存控制器

- 先进的调试和可视化工具

- 符合 CXL 标准的管理框架和实用程序

- 用于增值功能和供应商特定命令的可完全自定义的 SDK

如需详细了解 CXL PDK,请联系我们。

CXL 内存互连计划:引领数据中心架构新时代

为了应对数据呈指数级增长趋势所带来的挑战,整个行业即将迎来数据中心架构的突破性转变,这将从根本上改变全球数据中心的性能、效率和成本。近几十年来未有重大变化的服务器架构,如今正在其设计上迈出革命性的一步,以满足高级工作负载带来的日益增长的数据及性能需求。

来自博客

市场

Speed and Security for the Artificial Intelligence & Machine Learning Revolution

Catching a Tidal Wave of Data

Providing Performance & Security for the Connected Car

Securing Mission-critical Systems

Making IoT Data Safe & Fast